Bienvenidos a LXForce

- +5492645583108

- Ignacio de la Roza 160 Este - Of. 11 - Capital San Juan Argentina

- contacto@lxforce.com.ar

Bienvenidos a LXForce

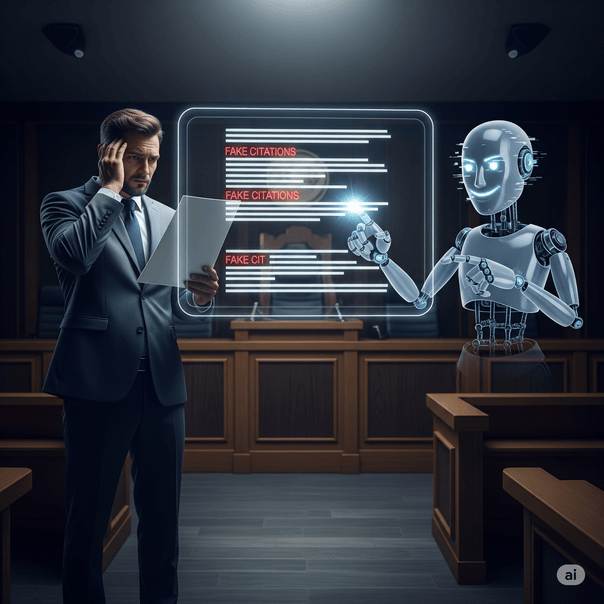

Lo que comenzó como una anécdota en los tribunales de Nueva York con el caso Mata vs. Avianca, se ha convertido en una realidad tangible en Argentina. La inteligencia artificial generativa, con su promesa de eficiencia y rapidez, ha mostrado su lado más peligroso: la capacidad de “alucinar”, de inventar datos con una verosimilitud alarmante. Y un abogado, actuando de buena fe, cayó en la trampa.

En la causa “G.C.A. Y OTROS c/ M.F.D Y OTROS s/ DAÑOS Y PERJUICIOS”, la Cámara de Apelación en lo Civil y Comercial de Rosario no solo resolvió un caso sobre un siniestro vial, sino que también nos dejó una de las advertencias más lúcidas y necesarias sobre el uso de herramientas como ChatGPT en la práctica jurídica.

El caso de fondo era relativamente sencillo. Un acuerdo transaccional por un accidente de tránsito no fue cumplido por la aseguradora. Los demandantes, ante la mora, solicitaron continuar con la demanda original. Para fundamentar su petición, su abogado presentó un escrito… y aquí es donde la tecnología hizo su entrada triunfal y problemática.

El escrito citaba jurisprudencia que apoyaba la postura de los actores. Los fallos parecían pertinentes, los argumentos coherentes. Pero había un problema: eran completamente falsos.

El juez Oscar Puccinelli, en un acto de debida diligencia, notó algo extraño. Las citas no le sonaban, no las encontraba. Como medida de mejor proveer, hizo algo simple y directo: le pidió al abogado que identificara la fuente de esa jurisprudencia.

La respuesta del letrado fue de una sinceridad admirable y, a la vez, profundamente preocupante: admitió que “utilizó un sistema de inteligencia artificial y que volcó el resultado encontrado de buena fe”. En resumen, confió ciegamente en el chatbot y nunca verificó las fuentes.

El juez Puccinelli reconoció la buena fe del profesional, pero fue implacable en su análisis sobre la responsabilidad que le cabe a un abogado. Calificó la conducta como “sumamente riesgoso y hasta temerario” y como una potencial violación a las normas de ética profesional.

El fallo es una pieza que todo abogado que use, o piense usar, IA debería leer. Sus puntos centrales son:

1. El Deber de Verificar es Indelegable: La responsabilidad de chequear las fuentes es una carga propia del abogado. No puede ser delegada en un software, por más avanzado que sea.

2. El Consentimiento del Cliente es Irrelevante: El juez va un paso más allá y aclara que, aunque el cliente hubiera autorizado el uso de IA, esto no libera al abogado de su responsabilidad. No se puede consentir una negligencia.

> “No puede haber consentimiento válido alguno que releve a un letrado de su deber de cotejar las fuentes en las que basa sus posiciones jurídicas”.

3. Violación de la Ética Profesional: El magistrado citó las Normas de Ética del Colegio de Abogados de Rosario, que exigen “lealtad personal, veracidad, buena fe” y prohíben “formulaciones o negaciones inexactas” o “citaciones tendenciosamente incompletas, aproximativas o contrarias a la verdad”. Usar una cita inventada, aunque sea sin intención, choca de frente con estos principios.

Quizás la medida más significativa del fallo no fue el reto al abogado, sino la decisión de oficiar al Colegio de Abogados de Rosario. El objetivo: “que tome conocimiento de la problemática suscitada por el uso irreflexivo de los resultados de consultas a chatbots con inteligencia artificial generativa”.

Esta decisión eleva el caso de una anécdota individual a una cuestión institucional. Es un llamado de atención para que los colegios profesionales tomen un rol activo en la formación y concientización sobre el uso ético y responsable de estas nuevas tecnologías.

El fallo de la Cámara de Rosario no es una condena a la inteligencia artificial. Es una advertencia sobre su uso acrítico. La IA puede ser una herramienta formidable para resumir textos, organizar ideas o incluso para tener un primer acercamiento a un tema. Pero no es, al menos por ahora, una fuente confiable de información jurídica.

Como bien concluye la sentencia:

> “Mientras los sistemas no se desarrollen al punto de no alucinar, es sumamente riesgoso y hasta temerario delegar la labor de búsqueda de jurisprudencia de soporte y luego volcarla sin cotejar la fuente, como aquí ocurrió”.

La lección es clara: el abogado del siglo XXI debe ser tecnológicamente curioso, pero profesionalmente escéptico. La eficiencia no puede comprarse al precio de la negligencia. La última palabra, y la responsabilidad final, sigue siendo humana.

1. ¿Qué es una “alucinación” de la IA?

Es un término usado para describir el fenómeno por el cual un modelo de lenguaje generativo (como ChatGPT) inventa información que no es real pero la presenta como un hecho verídico. Puede crear citas, biografías, eventos históricos, etc.

2. ¿El abogado fue sancionado?

El fallo no le impone una sanción directa, pero sí oficia al Colegio de Abogados para que investigue su conducta, lo que podría derivar en un proceso disciplinario.

3. ¿Está prohibido usar ChatGPT para el trabajo legal?

No, no está prohibido. Lo que está prohibido es presentar información falsa o no verificada. Se puede usar como asistente, pero el abogado es siempre el responsable final del contenido que presenta ante un tribunal.

4. ¿Cómo puedo verificar la jurisprudencia que me da una IA?

De la misma forma que se verifica cualquier otra fuente: acudiendo a los sistemas de consulta de jurisprudencia oficiales (como el CIJ, La Ley, El Derecho, etc.), buscando por el nombre de las partes, el número de expediente o la fecha del fallo.

5. ¿Por qué la IA inventa citas?

Estos modelos están diseñados para predecir la siguiente palabra más probable en una secuencia. Si un usuario le pide jurisprudencia, el modelo “sabe” cómo se ve una cita jurisprudencial (nombres, fechas, tribunal) y la construye, aunque no tenga un caso real que la respalde. Su objetivo es satisfacer al usuario, no decir la verdad.

6. ¿Qué rol deben cumplir los Colegios de Abogados frente a esta tecnología?

Deben educar y capacitar a sus matriculados sobre los riesgos y beneficios de la IA, establecer guías de buenas prácticas y, eventualmente, actualizar los códigos de ética para contemplar explícitamente el uso de estas herramientas.